- Detalhes adicionados sobre o treinamento Agentic do Kimimi-K2 e o Otimizador de Monclip

Moonshot Ai da China possui lunnave kimi-k2, novo wimot-4.1 aberto, wimout adcute pisando, por favor, com um lançamento de Mometsek Hime.

O Moonshot AI, Foubled em 2023, construiu o Kimi-K2 como modelo de mixitire-of-ethorts com um trills, ativando 32 contas por inferência. Pesos abertos o tornam acessível para aplicativos de pesquisa, ajuste fina e personalizado.

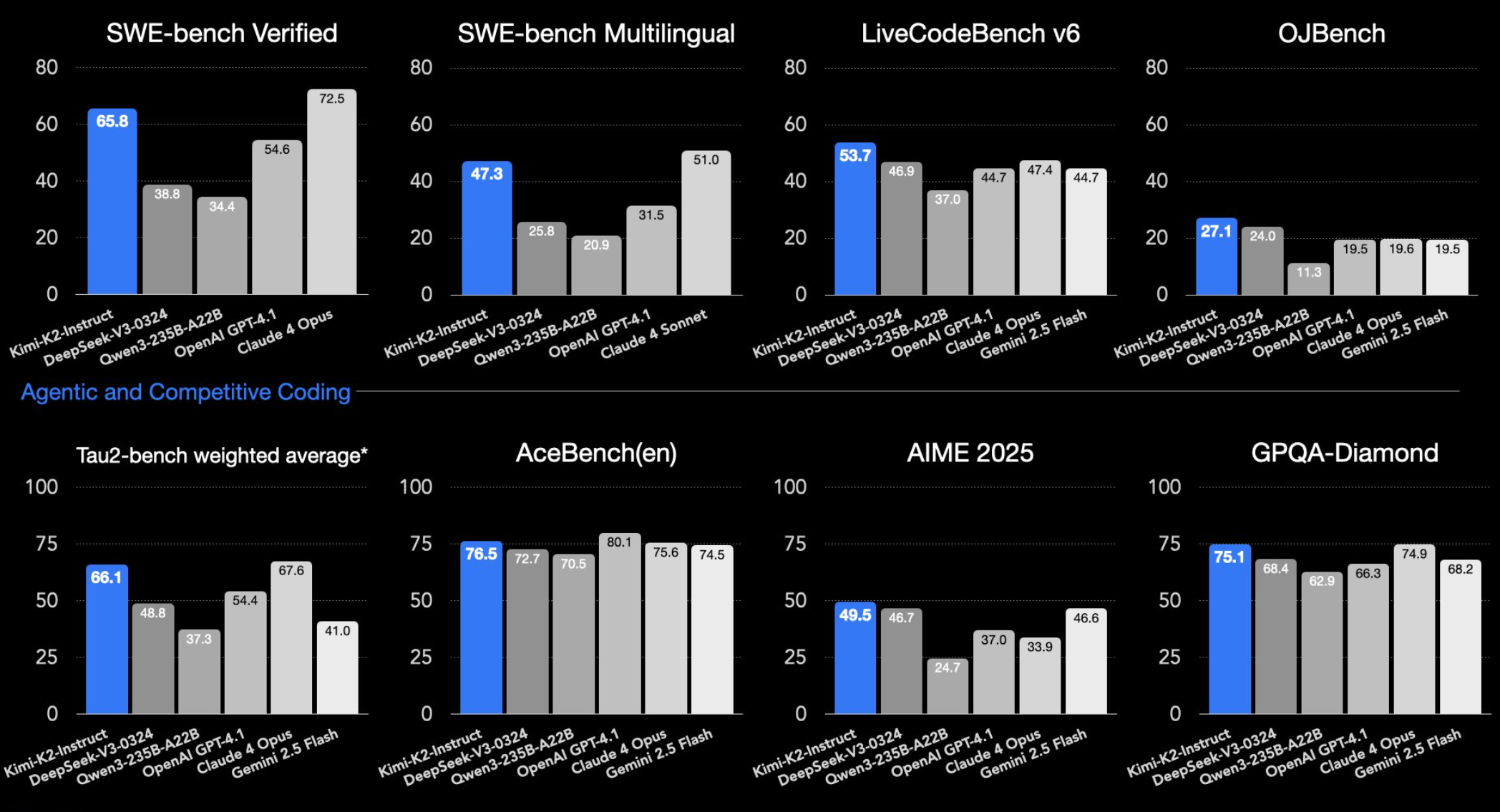

Nos benchmarks Standard LLM, Kimi-K2-Instruct-a versão otimizada para as terras de uso do mundo real nos modos dizendo. Sobre SWE-ben VerificadoEle obtém 65,8 % no modo de agente, apenas o Soneto 4 do Clade 4 e o Thenl antes do GPT-4.1 (54,6 %). O modelo BenMark Whath Wone pode identificar erros em projetos de código aberto.

Kimi-k2 Ales também lidera o pacote LivecodeBench (53,7 %) e Ojbench (27,1 %) sem o módulo de raciocínio. Os testes medem como os modelos de idioma abordam bem a programação-LivecodeBench interativamente, ojbench como tarefas tradicionais de crédito.

Anúncio

O Kimi-K2 se destaca em matemática e bobagens científicas também. Em Benchmarks Lime Aim, GPQA-Diamond e Math-500, ele supera seus cortadores. Ele também está entre os principais modelos de Tesus Schos multilíngues em Mmulun-PR. Moonshot Ai mostra os capitalidades codificadores da Kimi-K2 em X.

2. Uma bola pulando no Heegon pic.twitter.com/dhicknatd7

– Kimi.ai (@kimi_monshot) 11 de julho de 2025

Em um Teste não oficial de Simon WillisonKimi-K2 com sucesso de anriados com os anriados de Pelican em Bicycle-A Tasks Oods, o que cuidou das SPEs.

Construído para fluxos de trabalho Agentic

Moonshot AI diz que o Kimi-K2 é especificamente para aplicações agênticas. O modelo pode executar comandos, chamar ferramentas externas, genestate e código de depuração e lidar com tarefas complexas e em várias etapas.

Em Lee Demontration, o KMI-K2 analisou dados de vendas para trabalhos remotos e criou a página estatal html retomada.

Recomenda -se

Quando se trata de capacidades agênticas, o Kimi-K2 se destaca porque-como modelos típicos de raciocínio-foi treinado especificamente para ambientes agênticos e uso de ferramentas através do aprendizado de reforço. Acumulando para uma análiseO modelo AKIY não recebeu treinamento explícito em MOT ou ou cursos usando o raciocínio da cadeia de escritório de Atseveste. Isso sugere coisas para for for for for the precials agtlications, focando o uso de ferramentas e o fluxo de trabalho orquestal pode ser antes de pode ser o “raciocínio” de BEFORDAL.

Ainda são alguns limites. De acordo com a Koonhshot AI, tarefas do complexo Highul ou tocimentos não claros podem às vezes reesinar nas saídas da Lenghy. O modelo também realiza melhores sessões baseadas em agentes do INDAGOing do que os avisos de inserção e tiro único.

Kimi-K2 foi treinado em 15,5 trilhões de tonys usando de novo Algoritmo de treinamento chamado Monclip. Para impedir o treinamento de êxtase da instabilidade, monningclip -clipe regulares componentes -chave do atterismismo.

De acordo com o Koonhshot, essa abordagem mepta os preços de trens estáveis e sem raros livres-de-raros, assim como a escala. O otimizador de mononclip substitui o Widelf Udeed Adamw Pertimizer E é considerado um motivo essencial para o forte desempenho do modelo. A equipe diz que o Mononclip “supera substancialmente os formais” Adamw, que há muito tempo é considerado o padrão da indústria.

Otimizadores recalculares como ajustar o modelo PRAMETERS TERMATE TREINAMENTO Etapa para minimizar o ERRRS. Isso é especialmente importante para treinar muito o lago Kimi Kike Mojor Hajor Major Major Major Major Mansor para o desempenho de sobrefilação.

Implantação flexível, mas requisitos pesados

Kimi-K2 está avilável em duas versões: Kimi-K2-BASE Para pesquisa e ajuste personalizado, e KIMI-K2-INSTRUTA Para tarefas gerais de bate -papo e agente. Ambos os modelos podem ser acessados Drogh Anneai-Compaticle API na Plataforma da AI Moonshot. O preço é cronometrado: US $ 0,15 por milhão de entrada para acertos de cache, US $ 0,60 para erros de cache e US $ 2,550 por 2450 por 550 por 2450 por número de saídas.

Você também pode executar o Kimi-K2 localmente usando chinems de inferência como VLLM, SGLANG, Ktransormers, OPM. As instruções de configuração são Availle no Proesitorio Gítico Oficial.

O Ality É baseado no MIT, com a Onra requeren: se implantar kimi – muitos montive com um. Para a maioria das empresas, isso não será um problema.

A execução do Kimi-K2 Locarly ou em Scale é intensificador de hardware. Com o trilhão de parâmetros e 32 bilhões de ativação por inferência, o modelo requer Multi GPUs do PowerFum B200 no Hoppiders da NVIDIA. De acordo com o desenvolvedor da MLD da Apple Awnnun, Uma versão quantizada de 4 bits pode ser executada no TWE Siga M3 Ultra Machines com 512 GB de RAM cada.

No início deste ano, o Moonshot Ai ALSSSSSD também um modelo de raciocínio do que a Model Vision Model Relles Reledsed em abril.

Este artigo foi atualizado para incluir especulares sobre o treinamento de agentes da K2 e o Otimizador de Monclip.