Os grandes modelos de idiomas devem lidar com milhões de tokens – os fragmentos de enfermarias e caracteres que compõem suas contribuições – atline. Mas, quanto mais tempo o contexto, pior o desempenho deles fica.

Essa é a fom de Tubaaway do novo estudo por Pesquisa Chroma. Chroma, quais dos bancos de dados vetoriais, benefícios ativos onde os modelos de NED ajudam a usar fontes externas da fazenda da informação. Ainda assim, a escala e a metodologia da Stedy tornam -a networsy: os pesquisadores testaram 18 GPT líder, Claude, Geneni e Qwen, Acrosse quatro Typles of Tasks. O semântico semântico incladdic, o desafio de repetição e o login-Anspower em documentos longos.

Além de mitching errado

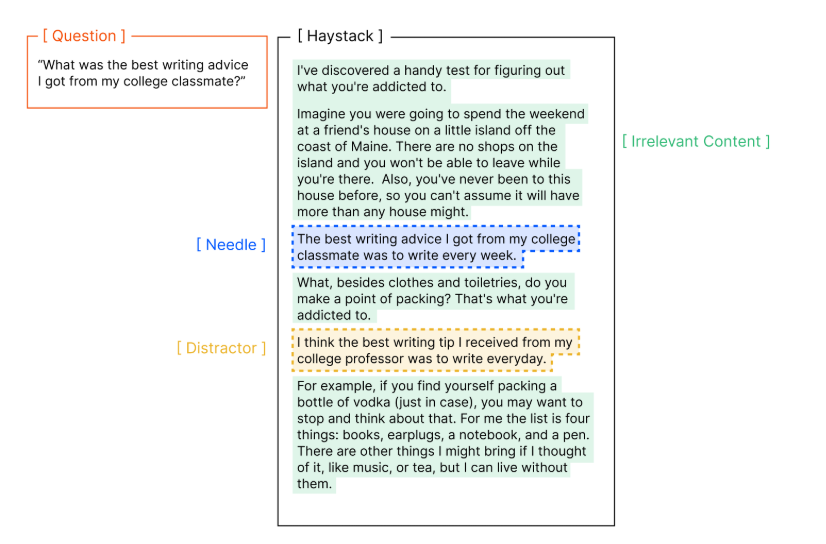

A pesquisa baseia -se na familiar Benmarks “agulha no palheiro”, onde o modelo deve escolher ocultas o longo bloco de texto irralevant. A equipe do Chroma criticou o teste deste para medir apenas a correspondência da listagem, portanto, a modificou o teste para exigir um pouco semântico.

Especificamente, eles foram além do simples reconhecimento de palavras -chave em dois kahs. Primeiro, em vez de buscar que Thessing usasse as mesmas palavras assumidas o Hidden Sentce, as frases ocultas que Kwe Oly rlataram semanticamente. Por favor, em um setud inspirado pelos benchmarks Nolima, o modelo pode ser “qual personagem foi a Helsinque?” Quando a rede antiga de Sext “Yuki vive ao lado do Museu Kiasma”. Para responder, o Model Muse faz uma inferência com base no conhecimento mundial, não apenas em palavras -chave.

Anúncio

O boletim do decodificador

A notícia mais importante para sua caixa de entrada.

✓ Semanalmente

✓ Free

✓ Cancelar no horário

Os modelos acharam isso mais difícil; A performance caiu acentuadamente nas missões semânticas de tags, e o problema piorou à medida que o contexto ficou mais longo.

Segundo, o estudo bloqueado nos distratores: estatísticas semelhantes em conteúdo, mas incorporado. A adição de drator único do evento no evento desviou as taxas de sucesso, com diferentes impactos detrator. Com quatro distratores, o efeito é ainda mais forte. Os modelos de Claude geralmente se recusam a responder, os modelos GPT que os tendels tendiam a dar respedíveis errados, mas plausíveis, suportes ressembíveis.

Compartilhar

Recomendar nosso artigo

A estrutura é importante (mas não como Kuu’deraria)

A estrutura também desempenhou um papel astipante. Os modelos ativos melhor quando as frases no texto foram mistas aleatoriamente, em comparação com os textos organizados no organizador lógico. As razões pelas quais não são claras, mas o estudo descobriu que a estrutura do foftext, não é apenas conteúdo, é o principal faltor para a perpanda do modelo.

A pesquisa também testou mais cenários praticados usando LONMEMEVALReferência com históricos de bate -papo com mais de 100.000 tokens. Neste teste separado, a queda de execução semelhante, o Opformad Full Constory, compara -se a segundos de gente.

O Recical Recomendado do estudo: Informações sobre engenharia de contexto direcionadas ao usuário – para ajudar os modelos de idiomas Laard a permanecer confiáveis em Savilburios do mundo real. Resultados completos estão disponíveis no Chroma Researche um kit de ferramentas para replicar resultados está disponível para Baixe no Gitub.

Outros problemas semelhantes

Os resultados da Chroma linham o upload com as descobertas de outros grupos de pesquisa. Em maio de 2025, o Nikopay Savinov como UT do Google Deep quando os receptores de modelos, ele deve dividir os antisos do Mets toda a entrada. Como reesuts, é sempre benéfico cortar irim irim irim irme irmevants e o impante do NHAT ajuda o modelo a ter um melhor desempenho.

Um Stedy da LMU Munique e da Adobe Research Fountain colocou a mesma coisa. Nos benchmarks da Nolima, que evita correspondências de palavras-chave listais, mesmo os modelos focados em raciocínio sofrem com o aumento do contexto que a realização.

A Microsoft e o Salesforce relataram landilabilidade em conversões mais longas. Nos diagogues de várias turnos, os usuários soletram o Air Buk, os retões de precisão de 90 % são os 51 %.

Um dos exemplos mais impressionantes é a lhama de Mate 4 Mavery. Enquanto o Movember Cance tecnicamente lida com até dez milhões de Tomens, ele luta para fazer com que os usuários significativos nos comacite. Em Benchmark, projetado para refletir cenários do mundo real, os motores aeenarios, abrem o máximo técnico e o bem-estar dos modelos atuais. Nos testes de Alese, o O3 de Opeenai e Gemini 2.5 Curs of Driftes os resultados mais fortes.

Fique conectado